ChatGPT sperren: So blockiert ihr die AI-Bots

26. September 2023

In einer Studie von Originality.ai wurde kürzlich bekanntgegeben, wie groß der Anteil der Top 1.000 Websites weltweit ist, die den GPTBot sperren.

Doch wie sieht das eigentlich in Deutschland aus? Diese Frage haben wir uns bei Claneo gestellt. Um dies herauszufinden, haben wir die genannte Studie adaptiert und uns die Top 1.000 Websites in Deutschland sowie die Websites der DESI250 angesehen.

Methodik:

- Identifikation der Top 1.000 Websites in Deutschland

- Analyse der DESI250

- Untersuchung der robots.txt jeder Website dahingehend, ob entweder der GPTBot, der ChatGPT-User oder der CCBot blockiert wurde

- Ausschluss von Websites aus der Analyse, die keine robots.txt haben oder wo diese nicht zugänglich war

- Erneute Wiederholung dieser Schritte drei Wochen später und Vergleich

Statistiken:

- Untersucht am 30.08.2023 und 22.09.2023

- 158 Websites untersucht (die anderen waren in beiden Listen enthalten)

- 129 robots.txt untersucht (die anderen Webseiten hatten keine oder es wurde zu diesem Zeitpunkt mindestens einer der Tests blockiert)

Inhaltsverzeichnis

ToggleWarum ist das relevant?

Large Language Models (LLMs) brauchen Daten, aus denen sie lernen können. Dafür wurden in der Vergangenheit bereits diverse Quellen herangezogen, u.a. Wikipedia, Bücher, gecrawlte Webseiten.

Diese gecrawlten Webseiten basieren z.B. auf verlinkten URLs auf Reddit mit mindestens drei Upvotes, und auf dem Datenset der Non-Profit-Organisation Common Crawl. Dieser Bot crawlt wohl das gesamte Internet und da es hier bereits vorhandene Datensets gibt, ist die eigene Website vermutlich bereits dort enthalten. Bei dem User Agent von Common Crawl handelt es sich um den CCBot, der durch die robots.txt blockiert werden kann. Allerdings verhindert das nur, dass die eigene Webseite zukünftig durch den Common Crawler durchstöbert wird. Die bereits vorhandenen Daten gehen dadurch nicht verloren.

Auch OpenAI greift auf diese Daten zu, gibt aber außerdem an, dass sie in Zukunft eventuell selbst Webseiten crawlen werden, um künftige Modelle zu trainieren (Quelle: https://platform.openai.com/docs/gptbot). Ob das passiert oder nicht, ist noch nicht klar. Es ist jedoch möglich, den Crawler GPTBot von OpenAI ebenfalls in der robots.txt zu blockieren. Dies verhindert allerdings nicht, dass die Daten nicht aus anderen Quellen herangezogen werden.

Darüber hinaus gibt es für ChatGPT ein Plugin, welches das Internet durchsucht. Da ChatGPT nur mit Daten bis 2021 trainiert wurde, ist dieses Plugin insbesondere dann praktisch, wenn Nutzende aktuellere Daten benötigen. Auch dieses Plugin lässt sich durch die robots.txt blockieren, wenn die eigenen aktuelleren Inhalte dort nicht zu finden sein sollen. Ältere Daten bleiben hingegen weiterhin vorhanden. Hier heißt der User Agent ChatGPT-User.

Was kann also getan werden, wenn der eigene Website-Content nicht von künstlicher Intelligenz untersucht werden soll? Es gibt mehrere Anweisungen, die dafür in der robots.txt hinterlegt werden können. Keine davon bietet allerdings eine Garantie.

Konkret könnten also folgende Instruktionen in die robots.txt integriert werden, wenn all die genannten Bots vom Crawling ausgeschlossen werden sollen:

User-agent: GPTBot

Disallow: /

User-agent: ChatGPT-User

Disallow: /

User-agent: CCBot

Disallow: /

Es muss aber nicht die gesamte Website vom Crawling ausgeschlossen werden. So lassen sich auch nur bestimmte Bereiche der Webseite sperren, z.B. durch

User-agent: GPTBot

Disallow: /verzeichnis-4/

Neben den User-Agents gibt es auch die Möglichkeit, bekannt IP-Adressen vom Crawling auszuschließen. Das lässt sich für Außenstehende jedoch nicht nachprüfen und es muss regelmäßig sichergestellt werden, dass diese noch aktuell sind.

Sollte ich die KI-Crawler in der robots.txt wirklich aussperren?

Diese Entscheidung muss natürlich jede:r Website-Betreiber:in selbst treffen.

Die Idee dahinter: Wenn meine Daten nicht durch die KI bereitgestellt werden, dann landen die Nutzenden weiterhin auf meiner Webseite und ich kann weiterhin durch diese Nutzenden Geld verdienen.

Auf der anderen Seite fehlen diese Daten dann künftig in KI-generierten Inhalten – und das kann so weit gehen, dass zu einer Marke nur Daten Dritter als Quelle genutzt werden und keine eigenen. Ist das wirklich erstrebenswert?

Es gibt hier aktuell kein Richtig und kein Falsch. Es gilt jedoch herauszufinden, welchen Weg man mit der eigenen Webseite gehen möchte.

Wie viele deutsche Webseiten schließen die Crawler aktuell aus?

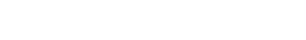

Insgesamt haben 17,4% der untersuchten robots.txt mindestens einen der untersuchten Bots blockiert (CCBot, GPTBot oder ChatGPT-User). Dabei waren es in der ersten Untersuchung nur 12,4%. Es ist also ein deutlicher Anstieg innerhalb von nur drei Wochen zu verzeichnen. In der o.g. weltweiten Studie waren es 18,6%. Diese Studie ist inzwischen allerdings auch ein paar Wochen alt und daher ist es nicht klar, ob der Anteil weiterhin aktuell ist.

Die Top-Webseiten (nach der Liste von DataforSEO) darunter sind:

- amazon.de (Platz 5)

- pinterest.de (Platz 11, im August wurde noch keiner der Bots blockiert)

- stern.de (Platz 23)

- sueddeutsche.de (Platz 25)

- welt.de (Platz 26)

- spiegel.de (Platz 29)

Im August gab es nur fünf Webseiten, die alle drei Crawler blockieren. Diese fünf Webseiten waren:

- glamour.de

- gq-magazin.de

- serienjunkies.de

- vimeo.com

- vogue.de

Im September waren es bereits zwölf Webseiten, die alle drei Crawler blockieren. Neu hinzugekommen sind mediamarkt.de, saturn.de, reuters.com, pharmazeutische-zeitung.de, fuersie.de, jolie.de und ok-magazin.de. Wobei reuters.com vorher bereits den CCBot und den GPTBot ausschloss, während die anderen sechs Domains zuvor gar keinen der untersuchten Bots ausgeschlossen haben.

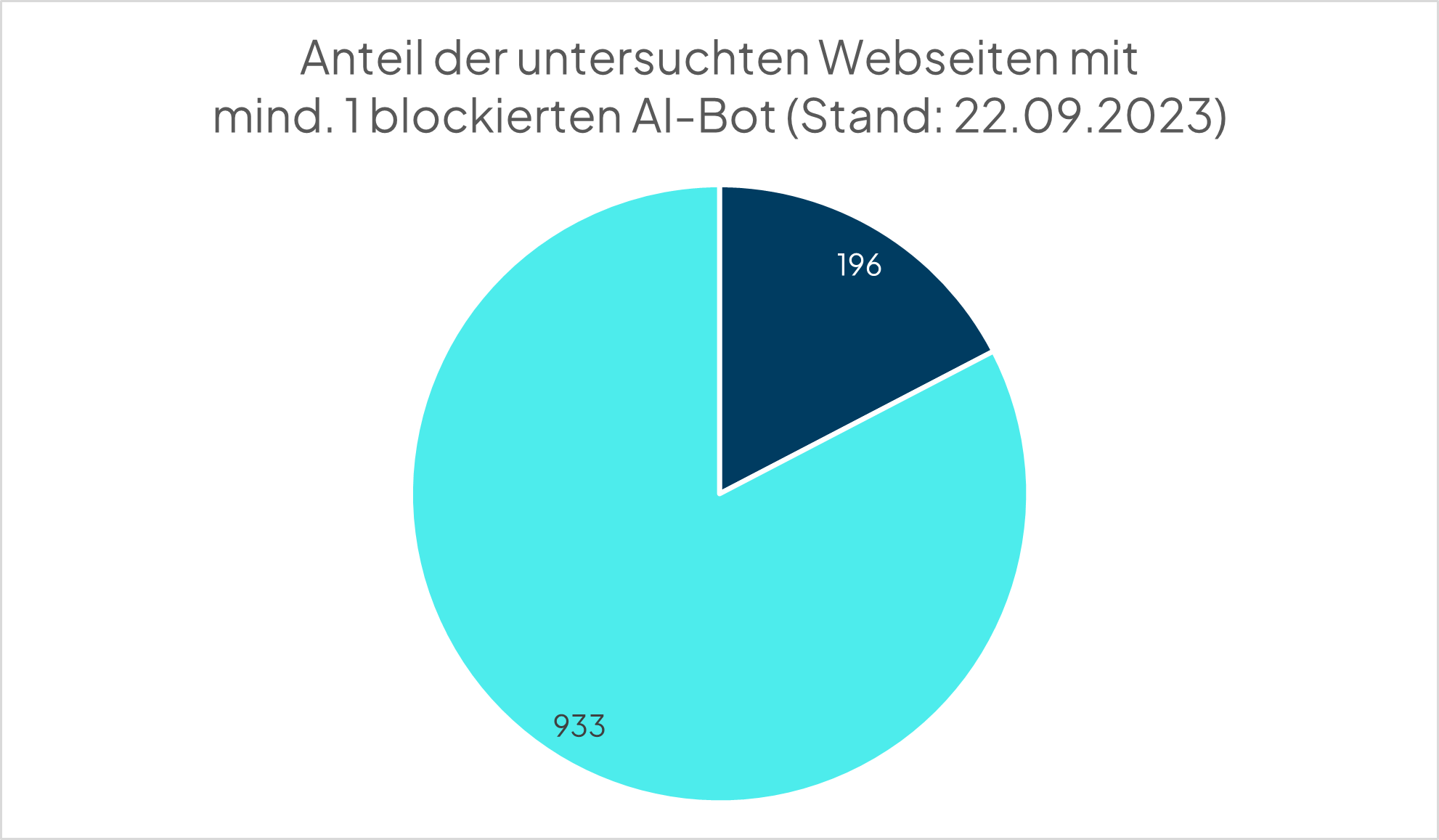

Der am häufigsten blockierte Crawler ist der von OpenAI (GPTBot). Immerhin 14,2% (im August waren es 8,9%) der untersuchten Webseiten blockieren diesen User Agent. Im August war der ChatGPT-User mit 3,9% der am zweithäufigsten geblockte User Agent. Im September stieg dieser Anteil auf 5,4%. Dagegen stieg der Anteil der Webseiten, die den Common Crawler blockieren von nur 3,2% im August auf 5,9% im September, sodass dieser nun der am zweithäufigsten geblockte Crawler ist.

OpenAI hat sich eventuell selbst ein Bein gestellt, als sie öffentlich bekannt gegeben haben, wie man den GPTBot in der robots.txt vom Crawling ausschließen kann. Die beiden anderen User Agents können zwar schon länger blockiert werden, dies setzen hingegen deutlich weniger Webseiten um.

Key Facts auf einen Blick

- 196 Webseiten blockieren mindestens einen der drei untersuchten Bots

- Der Anteil stieg innerhalb des Untersuchungszeitraumes um 40 %

- Zwölf Webseiten blockieren alle drei untersuchten Bots, wobei seit August sechs Webseiten dazugekommen sind, die vorher keinen der Bots blockierten

- 160 Webseiten blockieren den GPTBot (davon blockiert eine Webseite nur Teile der eigenen Inhalte)

- 66 Webseiten blockieren den CCBot

- 61 Webseiten blockieren den ChatGPT-User (davon blockiert eine Webseite nur Teile der eigenen Inhalte)