Folge 13: Grundbegriffe AI-Systeme (Teil 1) – Die 3 Typen im Vergleich

Im Dschungel der KI-Begriffe fällt es oft schwer, den Überblick zu behalten. Was ist eigentlich genau ein LLM? Ist ChatGPT dasselbe wie ein Sprachmodell? Und wie unterscheiden sich diese Systeme von AI Overviews in der Google-Suche?

In Folge 13 der GEO Know How Academy starten Magdalena Mues und Andre Alpar eine dreiteilige Deep-Dive-Serie in die Welt der AI-Systeme. Teil 1 legt das fundamentale Verständnis: Wir sortieren die Begrifflichkeiten, definieren die drei Kerntypen von AI-Systemen und blicken unter die Motorhaube, um zu verstehen, wie Inputs verarbeitet und Outputs generiert werden.

Denn nur wer versteht, wie diese Systeme technisch funktionieren, kann sie im Rahmen von GEO (Generative Engine Optimization) gezielt beeinflussen.

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr InformationenInhaltsverzeichnis

ToggleWarum wir Begriffe schärfen müssen

Oft werden Begriffe wie „LLM“ und „Chatbot“ synonym verwendet, was fachlich nicht korrekt ist. Ein LLM ist die Basistechnologie (der Motor), während ein Chatbot die Benutzeroberfläche (das Auto) ist.

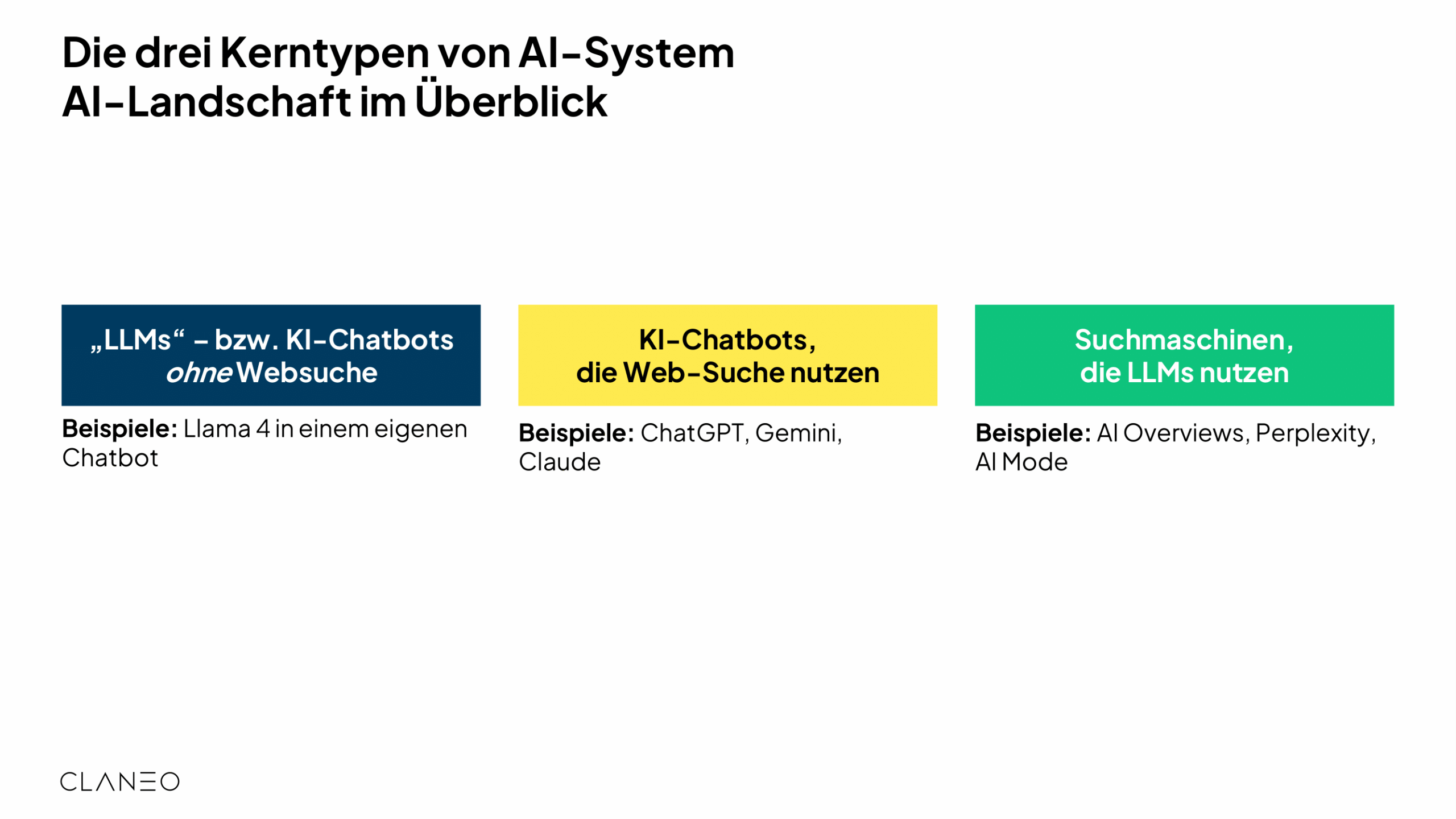

Um GEO professionell zu betreiben, ist eine präzise Unterscheidung notwendig. Wir unterteilen die AI-Landschaft daher in drei klare Kategorien.

Die 3 Typen von AI-Systemen im GEO-Kontext

Nicht jedes System funktioniert gleich. Die Unterscheidung ist entscheidend für die Frage, wie und ob man die Ergebnisse beeinflussen kann.

Dies sind geschlossene Systeme ohne Internetzugriff. Sie generieren Antworten ausschließlich aus ihren Trainingsdaten.

Beispiele: Llama 4 in einem internen Firmen-Chatbot.

GEO-Relevanz: Schwer kurzfristig zu beeinflussen, da man Teil der Trainingsdaten (Pre-Training) sein muss.

Diese Systeme nutzen ein LLM als Basis, können aber bei Bedarf auf das Internet zugreifen (RAG – Retrieval Augmented Generation), um aktuelle Informationen zu holen.

Beispiele: ChatGPT (mit Browsing), Google Gemini, Claude.

GEO-Relevanz: Gut beeinflussbar, da externe Quellen für aktuelle Antworten herangezogen werden.

Hier steht der Suchindex im Vordergrund. Das LLM wird genutzt, um die Suchergebnisse zusammenzufassen und zu ranken.

Beispiele: Google AI Overviews, Perplexity, AI Mode.

GEO-Relevanz: Basiert stark auf klassischem SEO-Index, aber mit neuen Ranking-Faktoren durch das LLM (z.B. Grounding).

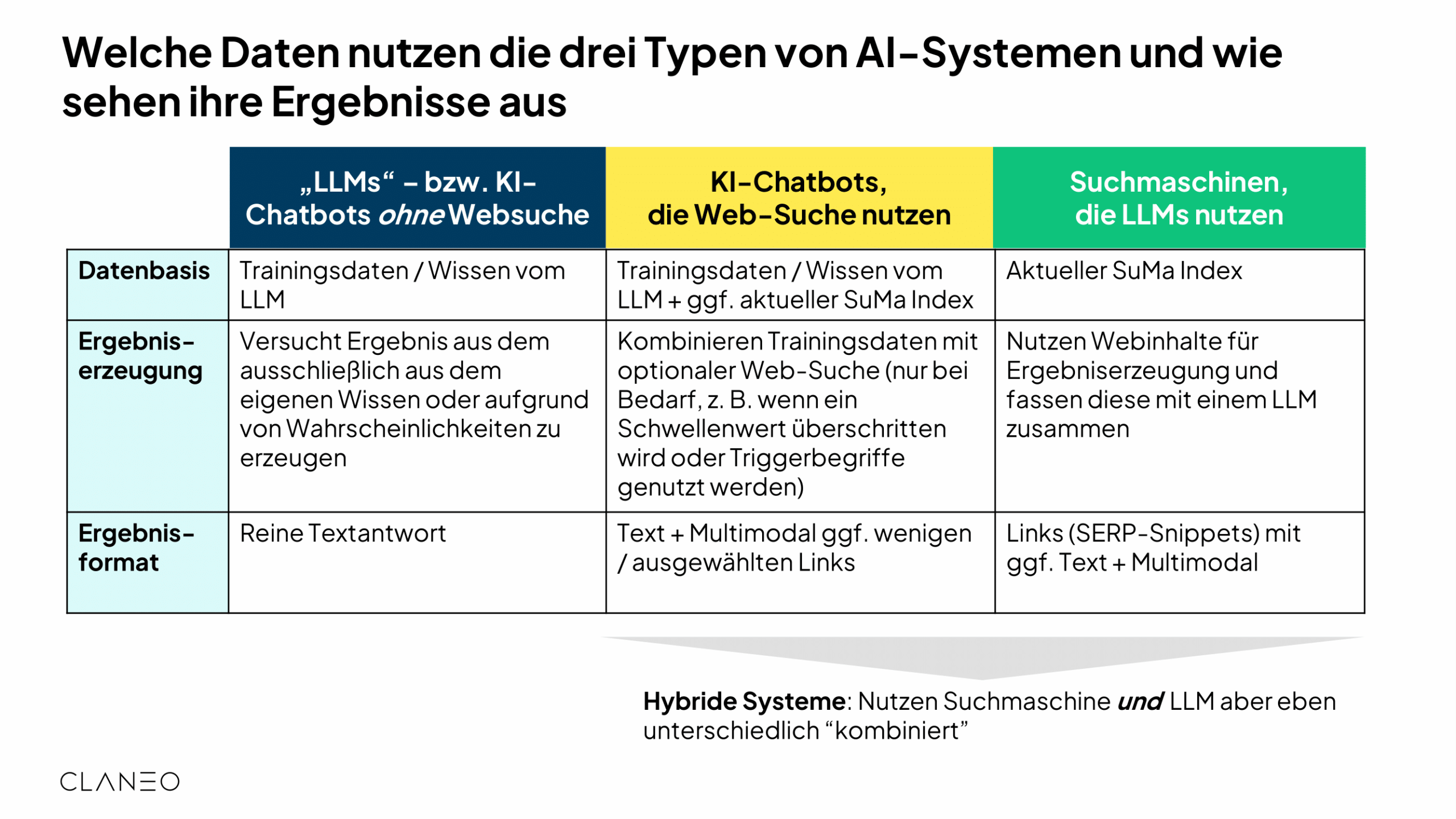

Der große Vergleich: Datenbasis und Ergebnisse

Wie unterscheiden sich diese Systeme in der Praxis? Die folgende Matrix zeigt, woher die Daten kommen und wie das Ergebnis aussieht. Besonders wichtig: Hybride Systeme (Typ 2 und 3) kombinieren Trainingsdaten mit aktuellen Web-Inhalten.

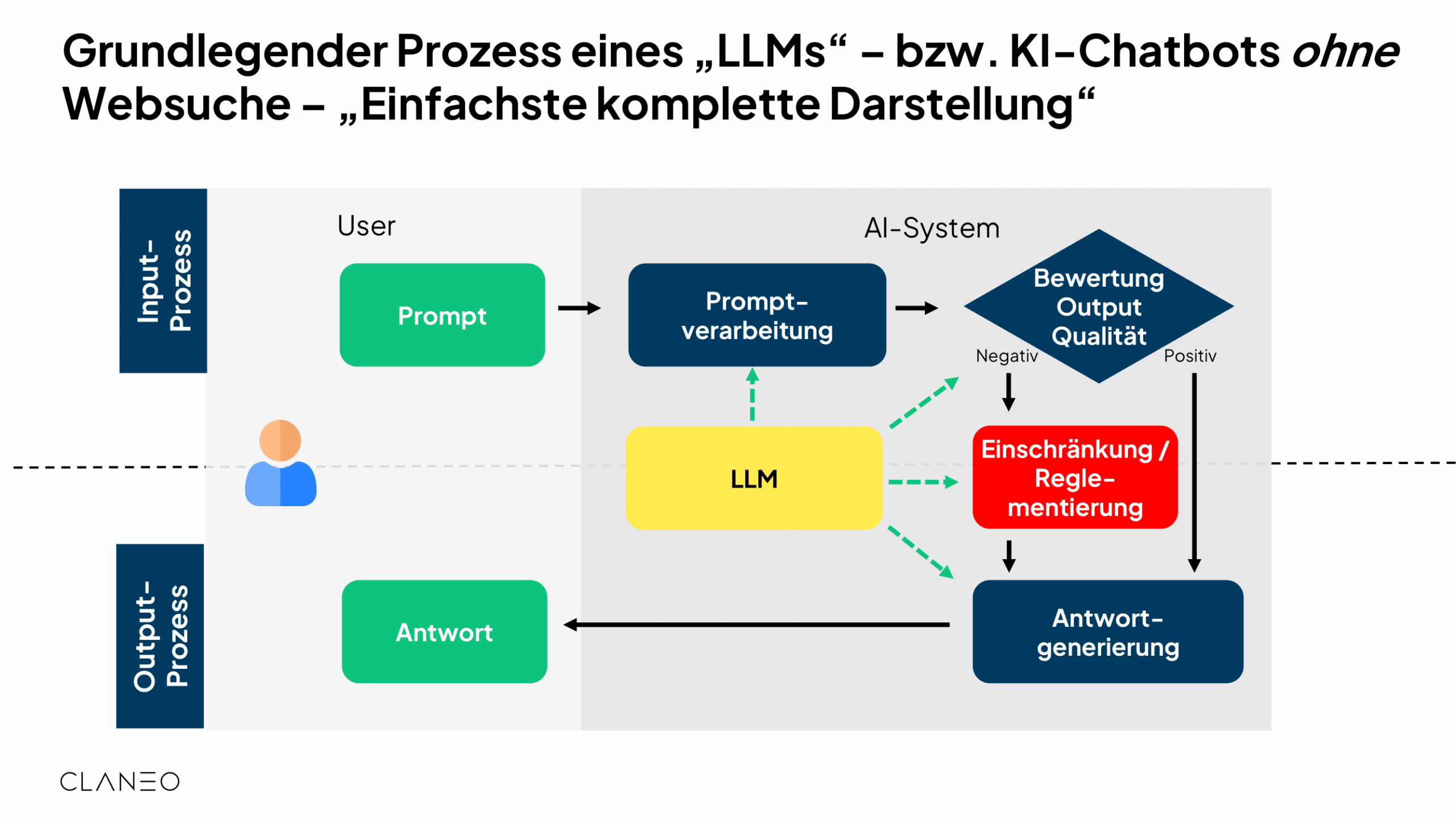

Hinter den Kulissen: Input- und Output-Prozesse

Was passiert eigentlich, wenn ein User einen Prompt eingibt? Der Prozess ist komplexer als eine einfache Datenbankabfrage. Er besteht aus Prompt-Verarbeitung (Intent-Erkennung, Tokenisierung), Bewertung der Output-Qualität und der eigentlichen Generierung.

Ein entscheidender Faktor: Die Qualitätsprüfung. Reicht das Wissen des Modells nicht aus oder verstößt die Anfrage gegen Sicherheitsrichtlinien (z.B. Anleitung zum Bombenbau), greifen Reglementierungen.

Trainingsdaten und Aktualität: Der Knowledge Cutoff

Ein reines LLM lernt nicht in Echtzeit. Das Training ist extrem aufwendig und teuer. Deshalb gibt es den sogenannten „Knowledge Cutoff“ – einen Stichtag, an dem der Wissenstand eingefroren wird.

Aktualisierungen erfolgen über:

- Fine-Tuning: Nachträgliches Training mit kleineren, spezifischen Datensätzen.

- RLHF (Reinforcement Learning from Human Feedback): Das System lernt aus dem „Daumen hoch / Daumen runter“ der Nutzer.

Für GEO bedeutet das: Wer in reinen LLMs sichtbar sein will, braucht einen langen Atem (Langzeitstrategie). Für schnelle Sichtbarkeit sind hybride Systeme mit Websuche (RAG) relevanter.

Fazit: Erst verstehen, dann optimieren

Folge 13 legt das Fundament. Wer den Unterschied zwischen einem reinen Sprachmodell und einer KI-gestützten Suchmaschine nicht kennt, wird die falsche Optimierungsstrategie wählen.

Key Takeaways:

- Unterscheide zwischen LLM (Basis) und Chatbot/Suche (Anwendung).

- Hybride Systeme sind der Schlüssel für GEO, da sie externe Daten (Websuche) nutzen.

- Der Input-Output-Prozess entscheidet darüber, ob deine Marke als Antwort generiert wird.

In den nächsten beiden Teilen der Serie tauchen wir noch tiefer in die technischen Details und die konkrete Beeinflussung dieser Systeme ein.