Folge 14: KI-Chatbots mit Websuche – Wie Gemini & Co. funktionieren

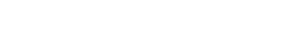

Nachdem wir in Folge 13 die Grundlagen von Large Language Models beleuchtet haben, tauchen wir heute tiefer in die Welt der hybriden KI-Systeme ein. KI-Chatbots wie Gemini, ChatGPT mit Websuche oder Perplexity kombinieren die Leistungsfähigkeit von Sprachmodellen mit aktuellen Informationen aus dem Web – eine Technologie, die das Suchverhalten grundlegend verändert.

In dieser Folge zeigen Magdalena Mues und Andre Alpar Schritt für Schritt, wie diese Systeme arbeiten: Von der Prompt-Verarbeitung über den Query-Fanout bis zur finalen Output-Generierung. Wer verstehen will, wie KI-Systeme Quellen auswählen, bewerten und zitieren, findet hier das technische Fundament für erfolgreiche GEO-Strategien.

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr InformationenInhaltsverzeichnis

ToggleHybride Suchsysteme: Die Verschmelzung zweier Welten

Hybride KI-Systeme vereinen zwei fundamentale Technologien: Large Language Models (LLMs) und klassische Suchmaschinen. Diese Kombination ermöglicht es, sowohl auf trainiertes Wissen als auch auf aktuelle Webinformationen zuzugreifen – ein entscheidender Vorteil gegenüber reinen Sprachmodellen.

Der Begriff „hybrid“ beschreibt präzise, wie diese Systeme arbeiten: Das LLM versteht die Nutzerintention und generiert die Antwort, während die Suchmaschine aktuelle, verifizierbare Informationen liefert. Die Art und Weise, wie diese beiden Komponenten zusammenarbeiten, unterscheidet sich jedoch fundamental zwischen verschiedenen Systemtypen.

Google AI Overviews vs. Gemini: Zwei Ansätze im Vergleich

Um die Unterschiede hybrider Systeme zu verstehen, lohnt sich der Vergleich zweier Google-Produkte, die auf denselben Grundtechnologien basieren, aber völlig unterschiedliche Anwendungsfälle bedienen.

Google AI Overviews

Primärer Zweck: Schnellere Zusammenfassung von Suchergebnissen

Integration: Teil der klassischen Suchergebnisliste

Darstellung: Zusammenfassung über den organischen Ergebnissen mit Quellenangaben

Fokus: Informationsaufbereitung für schnelle Antworten

Technologie: Spezialisierte, kompakte LLM-Version für hohe Geschwindigkeit

Gemini (KI-Chatbot)

Primärer Zweck: Universeller KI-Assistent für komplexe Aufgaben

Integration: Eigenständige App und Webseite

Darstellung: Konversationsbasierte Chat-Oberfläche mit multimedialen Elementen

Fokus: Interaktion, Problemlösung, Content-Erstellung

Technologie: Breit trainiertes Modell für vielfältige Anwendungsfälle

Die Funktionsweise von KI-Chatbots mit Websuche: Ein Blick in den Maschinenraum

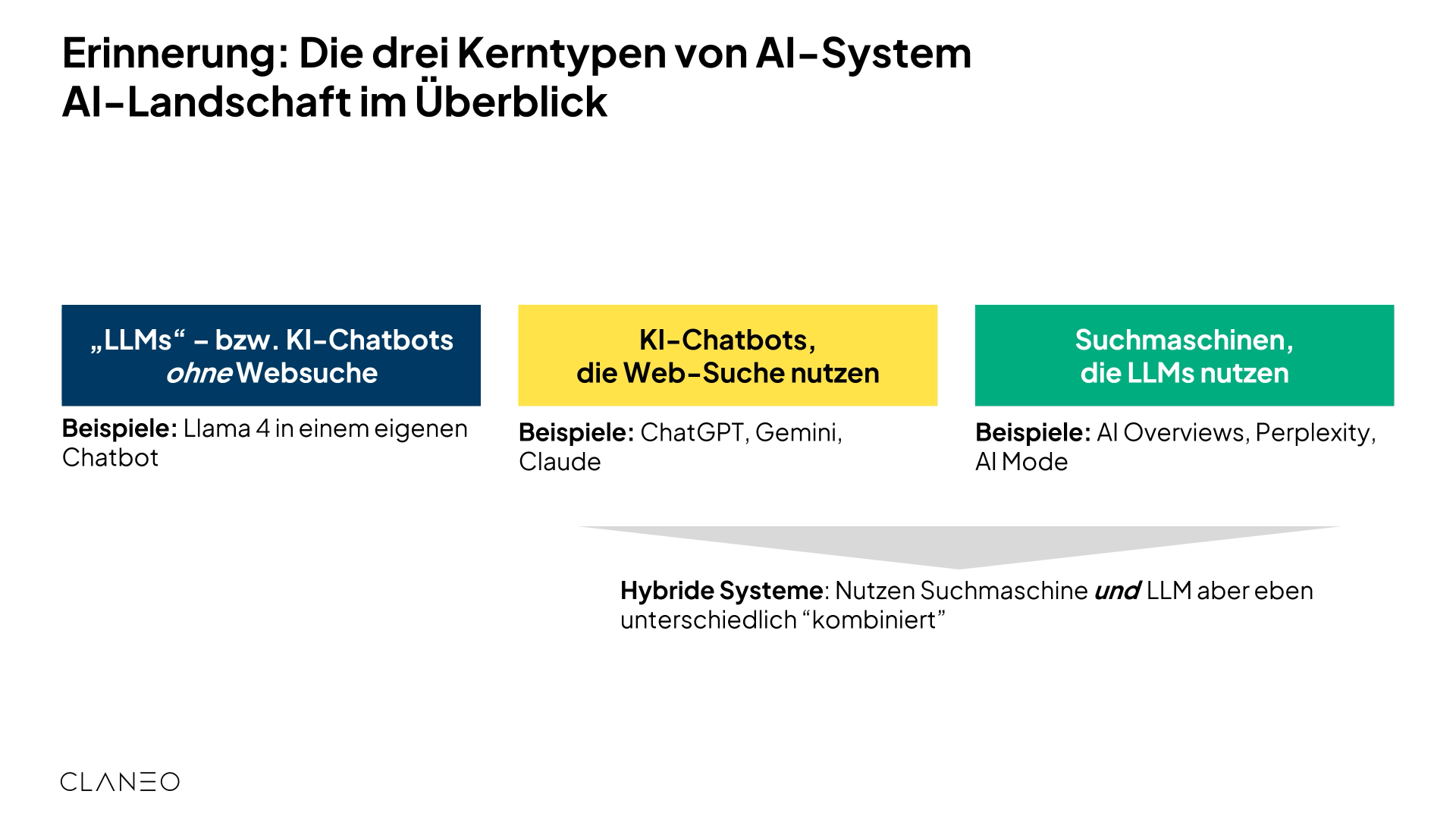

Der Prozess, wie ein KI-Chatbot mit Websuchfunktion arbeitet, lässt sich in mehrere klar definierte Schritte unterteilen. Jeder dieser Schritte ist entscheidend dafür, ob und wie eine Quelle im finalen Output erscheint.

Der Prozess beginnt mit dem User-Input – einem Prompt, der typischerweise länger und komplexer ist als eine klassische Suchanfrage. Beispiel: „Wer hat die EM 2024 gewonnen?“

Dieser Prompt wird an das KI-System übergeben und durchläuft die erste kritische Phase: die Verarbeitung durch das Large Language Model.

Im Herzen des KI-Systems findet die Prompt-Verarbeitung statt. Hier kommen drei wesentliche Komponenten zusammen:

Das LLM: Das Sprachmodell als Herzstück des Systems

Der Kontext: Standort, Tageszeit, Nutzerpräferenzen, Gesprächshistorie

Der Prompt: Die eigentliche Anfrage

Die Verarbeitung erfolgt in drei Teilschritten:

- Sprachanalyse und Intenterkennung: Wie komplex ist die Anfrage? Handelt es sich um aktuelles Wissen oder Grundlagenwissen? Welche Absichten stehen dahinter?

- Entitäten-Extraktion: Zerlegung des Prompts in logische Elemente („EM“ = Sportereignis Europameisterschaft, „2024“ = Jahreszahl, nicht mathematische Zahl)

- Kontextualisierung: Integration von Kontextinformationen in die Interpretation

Nach der Prompt-Verarbeitung bewertet das Sprachmodell, ob es aus dem eigenen trainierten Wissen eine ausreichend gute Antwort generieren kann.

Hier kommt ein Schwellenwert (Confidence Threshold) zum Einsatz, der in Systemen wie ChatGPT bekannt geworden ist:

- Output gut genug: Direkte Antwortgenerierung aus dem LLM-Wissen

- Output nicht ausreichend: Übergang zum Grounding-Prozess mit Websuchintegration

Diese Bewertung entscheidet fundamental darüber, ob externe Quellen überhaupt zum Einsatz kommen – ein kritischer Moment für jede GEO-Strategie.

Wenn der Schwellenwert überschritten wird, startet der Grounding-Prozess – die Suche nach einer soliden Datenbasis für die Antwort.

Kernmechanismus ist der Query-Fanout (auch Synthetisierung genannt):

Das KI-System zerlegt den komplexen Prompt in mehrere einfachere Suchanfragen (Queries), die an die Suchmaschine gesendet werden. Jedes Teilproblem wird mit einer spezifischen Query adressiert.

Wichtige Nomenklatur:

- LLM: KI-System, das nur auf eigene Wissensbasis zugreift

- RAG (Retrieval-Augmented Generation): Gesamtsystem ab dem Moment, wo auf externe Daten (Suchmaschine) zugegriffen wird

Der Grounding-Prozess stellt sicher, dass die Antwort auf verifizierbaren, aktuellen Informationen basiert – nicht nur auf möglicherweise veraltetem Trainingswissen.

Die Suchmaschine verarbeitet die vom KI-System generierten Queries und liefert Ergebnisse zurück. Allerdings unterscheiden sich diese Daten fundamental von dem, was normale Nutzer:innen sehen:

Was das KI-System erhält:

- Domain der Quelle

- Art des Ergebnisses

- Konkrete URL

- Titel der Seite

- Kurze Zusammenfassung (Snippet)

- Metadaten

Was das KI-System NICHT erhält:

- Personalisierte Ergebnisse

- Multimediale Einspielungen (Bilder, Videos, News-Boxen)

- Visuelle Formatierungen

Die Suchmaschine liefert eine standardisierte, strukturierte Datei im maschinenlesbaren Format – optimiert für die Weiterverarbeitung durch das LLM, nicht für menschliche Augen.

Nachdem die Daten von der Suchmaschine zurückgekommen sind, bewertet das KI-System deren Qualität und Vollständigkeit. Mehrere Faktoren spielen eine Rolle:

Antworttyp:

- Kurze, globale Antwort → Snippets können ausreichen

- Komplexe, detaillierte Antwort → Tiefere Daten erforderlich

Quellenbewertung:

- Hohe Konfidenz: Autoritative, vertrauenswürdige Quellen (Nachrichtenseiten, offizielle Websites)

- Niedrige Konfidenz: User Generated Content, unsichere Quellen

Konsistenz-Prüfung:

- Stimmen die Informationen aus verschiedenen Quellen überein?

- Gibt es Widersprüche? (Beispiel: Verschiedene „Gewinner“ der EM 2024)

- Sind die Daten präzise und vollständig?

Bei unklaren oder widersprüchlichen Daten reichen die Snippets nicht aus – das System geht zum nächsten Schritt über.

Wenn die abstrakten Daten aus den Snippets nicht ausreichen, startet der Deep Crawl:

Das System besucht ausgewählte URLs aktiv und extrahiert den vollständigen HTML-Content. Ein Crawler holt sich die komplette Webseite und generiert daraus einen rohen Textblock – eine deutlich ausführlichere Version als das ursprüngliche Snippet.

Der Unterschied:

- Snippet-Daten: Wie die Suchergebnisseite bei Google (Titel + kurze Beschreibung)

- Deep Crawl: Wie das Anklicken jeder einzelnen Webseite und Lesen des kompletten Textes

Dieser Schritt ist ressourcenintensiv, liefert aber die Informationstiefe, die für komplexe, präzise Antworten erforderlich ist.

Am Ende des Prozesses steht die finale Output-Generierung. Hier gibt es drei mögliche Wege:

1. Direkte LLM-Antwort:

Das Sprachmodell generiert aus eigenem Wissen/Synthetisierung eine Antwort ohne externe Quellen

2. Snippet-basierte Antwort:

Grounding mit Suchmaschinen-Daten, Antwort basiert auf Snippets und Metadaten

3. Deep-Crawl-basierte Antwort:

Grounding mit vollständigem Website-Content für maximale Präzision und Tiefe

Wichtige Terminologie:

Wir sprechen bewusst von „Output“ statt „Antwort“, da KI-Systeme nicht nur Fragen beantworten, sondern auch Content erstellen (Create-Intent). Der Begriff „Output“ erfasst die volle Bandbreite der Nutzungsintentionen – von Information über Navigation bis hin zu kreativer Content-Generierung.

GEO-Implikationen: Was bedeutet das für die Praxis?

Das Verständnis dieser technischen Prozesse ist kein Selbstzweck – es bildet das Fundament für strategische GEO-Entscheidungen.

Snippet-Optimierung ist kritisch

Snippets und Metadaten sind oft die erste Datenquelle für KI-Systeme. Strukturierte Daten, präzise Meta-Descriptions und klare Titel erhöhen die Wahrscheinlichkeit, dass Content bereits auf Snippet-Ebene überzeugt.

Content-Tiefe entscheidet

Wenn KI-Systeme zum Deep Crawl übergehen, zählt die Qualität des vollständigen Contents. Gut strukturierte, faktendichte Texte mit klaren Aussagen werden bevorzugt verarbeitet und zitiert.

Konsistenz schafft Vertrauen

Die Konsistenz-Prüfung zeigt: Widersprüchliche Informationen führen zu tieferen Recherchen oder Ausschluss. Faktentreue und Übereinstimmung mit anderen autoritativen Quellen sind essentiell.

Thematische Breite zahlt sich aus

Der Query-Fanout zerlegt komplexe Prompts in mehrere Suchanfragen. Content sollte nicht nur ein Hauptthema abdecken, sondern auch verwandte Teilaspekte – so wird die Wahrscheinlichkeit erhöht, bei mehreren Queries zu erscheinen.

Autorität wird algorithmisch bewertet

Quellen mit hoher Autorität und Vertrauenswürdigkeit werden vom System bevorzugt. Domain-Reputation, E-E-A-T-Signale und journalistische Standards beeinflussen die Quellenbewertung fundamental.

Create-Intent berücksichtigen

KI-Systeme bedienen nicht nur Informationsbedürfnisse, sondern auch kreative Anwendungsfälle (Create-Intent). Content, der als Baustein für neue Inhalte dient – Daten, Code, Vorlagen, Beispiele – gewinnt an Bedeutung.

Ausblick: LLM-gestützte Suchmaschinen in Folge 15

In dieser Folge haben wir die Funktionsweise von KI-Chatbots mit Websuche detailliert analysiert – Systeme wie Gemini, ChatGPT mit Browsing oder Perplexity, bei denen das LLM im Zentrum steht und die Suchmaschine als Werkzeug nutzt.

In der nächsten Folge drehen wir die Perspektive um und betrachten LLM-gestützte Suchmaschinen wie Google AI Overviews. Hier steht die Suchmaschine im Zentrum, und das LLM dient der Aufbereitung und Zusammenfassung. Die Unterschiede sind subtil, aber für GEO-Strategien hochrelevant.

Wer beide Systemtypen versteht, kann Content gezielt so optimieren, dass er in der gesamten Bandbreite hybrider KI-Systeme performt.

Weitere GEO Know How Folgen