Folge 15: Suchmaschinen, die LLMs nutzen – Wie Google AI Overviews funktionieren

Nach den ersten beiden Teilen unserer dreiteiligen Serie zu KI-Systemen wird es jetzt konkret: Wie funktionieren Suchmaschinen, die Large Language Models nutzen? In dieser Folge analysieren wir am Beispiel der Google AI Overviews den kompletten Prozess – von der Suchanfrage über die Eignungsprüfung bis zur finalen Ausspielung.

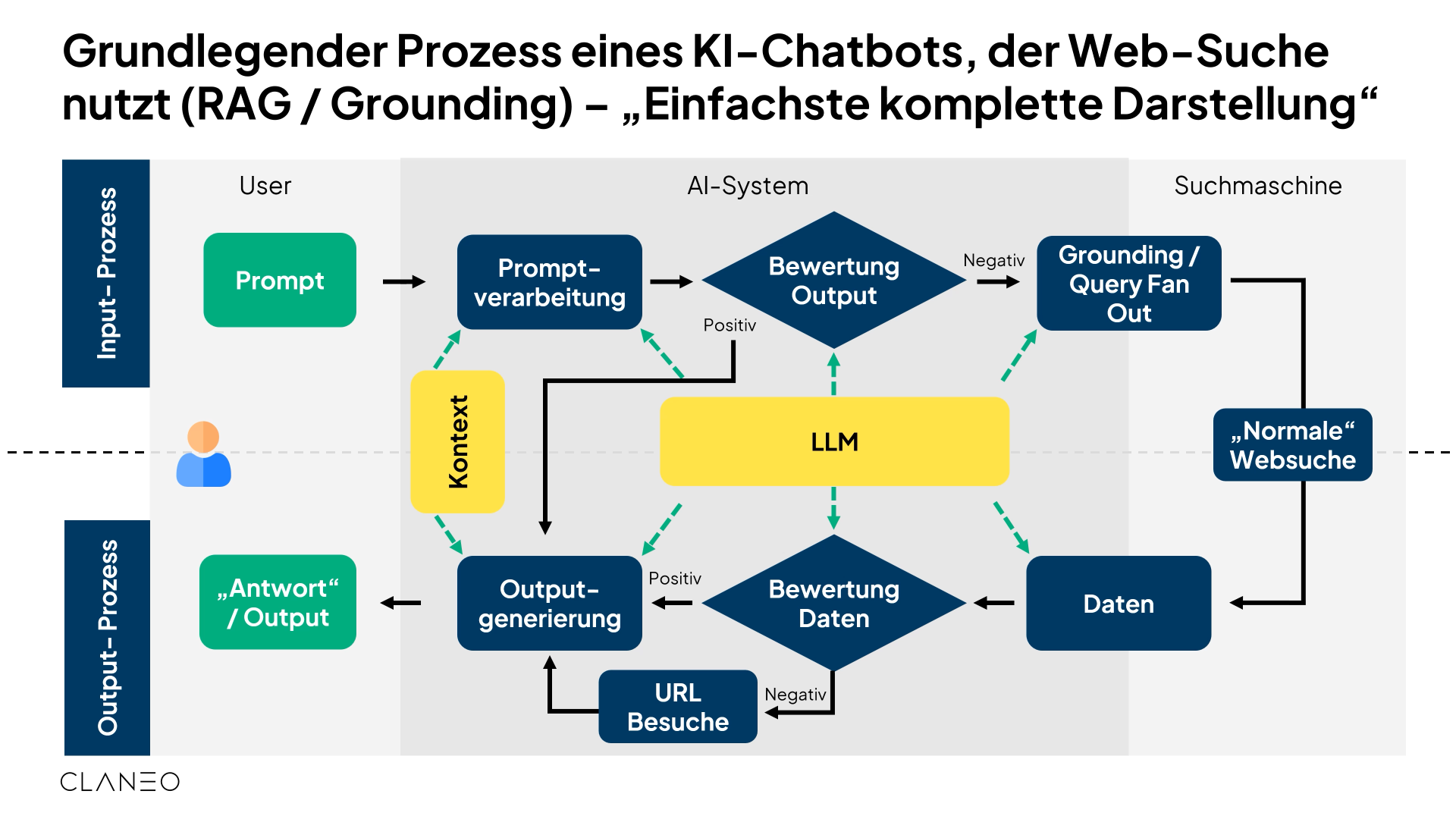

Während in Folge 14 KI-Chatbots im Fokus standen, die auf Websuchmaschinen zugreifen, dreht sich heute alles um den umgekehrten Fall: Suchmaschinen, die KI-Modelle als nachgelagertes System einsetzen. Das Verständnis dieser Architektur ist entscheidend für erfolgreiche GEO-Strategien.

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr InformationenInhaltsverzeichnis

ToggleRückblick: Die drei Typen von KI-Systemen aus GEO-Perspektive

Bevor wir in die Details der AI Overviews eintauchen, eine kurze Erinnerung an die Systematik, die wir in den vorherigen Folgen entwickelt haben:

LLMs ohne Websuche

Reine Sprachmodelle ohne externen Datenzugriff. Die Antworten werden ausschließlich aus dem trainierten Modellwissen generiert.

Beispiel: Llama 4 in einem eigenen Chatbot

KI-Chatbots mit Websuche

KI-Chatbots, die aktiv auf Suchmaschinen zugreifen, um ihre Antworten mit aktuellen Webdaten anzureichern.

Beispiele: ChatGPT, Gemini, Claude

Suchmaschinen mit LLMs

Suchmaschinen, die Large Language Models nachgelagert einsetzen, um Suchergebnisse zu synthetisieren.

Beispiele: Google AI Overviews, Perplexity, Bing AI Mode

Der entscheidende Unterschied: Bei den AI Overviews ist die Suchmaschine das primäre User Interface, nicht der KI-Chatbot. Das KI-System arbeitet im Hintergrund und wird nur dann aktiviert, wenn bestimmte Bedingungen erfüllt sind.

Die Architektur: User, Suchmaschine und KI-System im Zusammenspiel

Bei Suchmaschinen, die LLMs nutzen, verläuft die Interaktion grundlegend anders als bei KI-Chatbots. Der Nutzer gibt keine komplexen Prompts ein, sondern klassische Suchanfragen (Queries). Diese werden zunächst von der Suchmaschine verarbeitet – das KI-System kommt erst im zweiten Schritt ins Spiel.

Schritt 1: Query-Verarbeitung und Kontextanreicherung

Wenn eine Suchanfrage eingeht, beginnt die Suchmaschine mit der Query-Verarbeitung. Im Vergleich zu komplexen Prompts sind Suchanfragen in der Regel kompakter und einfacher strukturiert. Dennoch findet eine wichtige Kontextanreicherung statt:

Die Suchmaschine berücksichtigt individuelle Präferenzen, frühere Suchanfragen und Nutzerverhalten, um die Query besser zu verstehen.

Für bestimmte Suchanfragen ist die Tageszeit relevant – etwa bei Suchanfragen zu Restaurants oder Öffnungszeiten.

Der Standort des Suchenden wird einbezogen, um lokale Relevanz zu gewährleisten – besonders wichtig bei standortbezogenen Anfragen.

Schritt 2: Eignungsprüfung – Wird ein AI Overview ausgespielt?

Nach der Query-Verarbeitung folgt eine entscheidende Weichenstellung: Ist diese Suchanfrage überhaupt geeignet für ein AI Overview? Google kommuniziert klar, dass AI Overviews nur dann ausgespielt werden, wenn sie einen echten Mehrwert bieten. Doch was bedeutet das konkret?

Wann werden KEINE AI Overviews ausgespielt?

Google hat klare Kriterien definiert, wann AI Overviews nicht angezeigt werden. Das Verständnis dieser Ausschlusskriterien ist für GEO-Strategien essenziell:

Wenn eine einfache Liste von Links die bessere oder direktere Antwort liefert, verzichtet Google auf AI Overviews. Die KI-Zusammenfassung muss einen additiven, ergänzenden Nutzen haben – andernfalls bleiben klassische Suchergebnisse die bessere Wahl.

Bei hochsensiblen, expliziten oder gefährlichen Themen werden keine AI Overviews generiert. Google hat seine Systeme darauf trainiert, solche Anfragen zu erkennen und auszuschließen – etwa bei Anleitungen zu gefährlichen Handlungen oder medizinischen Notfällen.

Wenn für eine Suchanfrage nicht genügend qualitativ hochwertige Informationen im Web verfügbar sind, schränkt Google die Anzeige ein. Dies betrifft insbesondere ungewöhnliche, unsinnige oder sehr nischige Anfragen, bei denen die Gefahr irreführender oder satirischer Inhalte besteht.

Bei Suchen mit klarer Kaufabsicht (z.B. „Samsung Handy kaufen“) wird oft kein AI Overview angezeigt. Nutzer:innen wollen hier Produkte, Preise und Händler sehen – keine technische Zusammenfassung. Zudem ist dies der Bereich, in dem Google mit Werbung Umsatz generiert. AI Overviews würden hier das kommerzielle Geschäftsmodell kannibalisieren.

Bei sehr aktuellen Nachrichtenlagen werden oft keine AI Overviews ausgespielt. Die Faktenlage ändert sich schnell, eine gründliche Verifizierung ist schwierig. Das KI-System kann die verschiedenen neuen Quellen nicht zügig genug prüfen, um qualitativ hochwertige Zusammenfassungen zu garantieren.

GEO-Implikation: Nicht jede Suchanfrage ist GEO-relevant. Die strategische Priorisierung sollte sich auf informative, komplexe Queries konzentrieren, bei denen AI Overviews tatsächlich ausgespielt werden. Transaktionale Keywords bleiben primär SEO- und SEA-Territorium.

Schritt 3: Datenabruf und Query Fan-Out

Wenn die Eignungsprüfung positiv ausfällt, beginnt der eigentliche Prozess der Informationsbeschaffung. Hier gibt es zwei Szenarien:

Einfache Queries

Bei einfachen, klar formulierten Suchanfragen holt das KI-System die Daten direkt aus dem normalen Suchindex. Die Query wird wie bei klassischen Suchanfragen verarbeitet.

Komplexe Queries

Bei komplexeren Anfragen, die in Richtung Prompts gehen, kann das System einen Query Fan-Out durchführen: Die komplexe Anfrage wird in mehrere synthetische Suchanfragen aufgeteilt. Zu jeder dieser Teil-Queries werden Daten aus dem Index abgerufen. Diese angereicherten Informationen bilden dann die Basis für die AI Overview-Generierung.

Der Query Fan-Out ist ein entscheidender Mechanismus: Das KI-System zerlegt eine komplexe Frage in mehrere Teilaspekte, sucht zu jedem Aspekt separat und synthetisiert dann alle Ergebnisse zu einer kohärenten Antwort.

Schritt 4: Output-Generierung und Bewertung

Nachdem die relevanten Daten aus dem Index abgerufen wurden, generiert das Large Language Model einen ersten Output. Doch damit ist der Prozess noch nicht abgeschlossen – es folgt eine kritische Bewertungsphase.

Chunking: Bewertung in Teilelementen

Das System bewertet nicht den kompletten Output als Ganzes, sondern zerlegt ihn in einzelne Teilelemente (Chunks). Jedes dieser Chunks wird separat auf Qualität, Konsistenz und Verlässlichkeit geprüft.

Zwei mögliche Bewertungsergebnisse

Nach der Bewertung gibt es zwei Szenarien:

Positive Bewertung → Direkte Ausspielung

Wenn die Bewertung positiv ausfällt, wird der AI Overview direkt ausgespielt. Das System ist überzeugt, dass die generierte Zusammenfassung qualitativ hochwertig, konsistent und hilfreich ist.

Negative Bewertung → Iteration oder Abbruch

GEO-Implikation: Konsistenz und Qualität der Quellen sind entscheidend. Wenn verschiedene Quellen widersprüchliche Informationen liefern, kann das System keinen verlässlichen AI Overview generieren. Einheitliche, gut strukturierte und verifizierbare Inhalte erhöhen die Wahrscheinlichkeit, als Citation genutzt zu werden.

GEO-Implikation: Konsistenz und Qualität der Quellen sind entscheidend. Wenn verschiedene Quellen widersprüchliche Informationen liefern, kann das System keinen verlässlichen AI Overview generieren. Einheitliche, gut strukturierte und verifizierbare Inhalte erhöhen die Wahrscheinlichkeit, als Citation genutzt zu werden.

Der vollständige Prozess im Überblick

Fassen wir den gesamten Ablauf zusammen – von der Suchanfrage bis zur finalen Ausspielung:

- Query-Verarbeitung: Kontextanreicherung durch Personalisierung, Zeit und Ort

- Eignungsprüfung: Entscheidung, ob AI Overview sinnvoll ist

- Datenabruf: Direkt aus Index oder via Query Fan-Out

- Output-Generierung: LLM erstellt erste Zusammenfassung

- Bewertung: Qualitätsprüfung der einzelnen Chunks

- Ausspielung oder Iteration: Entweder direkte Anzeige oder erneute Suche

Dieser mehrstufige Prozess zeigt: AI Overviews sind keine einfachen Textgenerierungen, sondern das Ergebnis komplexer Qualitätssicherungsmechanismen.

Exkurs: AI Overviews vs. AI Mode – Gemeinsamkeiten und Unterschiede

Beide Systeme nutzen die gleiche grundlegende Architektur – Suchmaschine plus LLM –, unterscheiden sich aber in Positionierung, Interaktivität und Zielsetzung:

Google AI Overviews

- Erscheinungsort: Direkt in den regulären SERPs, oberhalb der organischen Treffer

- Format: Kompakte, statische Zusammenfassungen (Text, Listen, Tabellen)

- Zweck: Schnelle, prägnante Antworten auf gängige, informative Suchanfragen

- Interaktion: Wenig oder keine Folgefragen möglich

- Use Cases: „Was ist X?“, „Wie funktioniert Y?“, einfache Faktenabfragen

Google AI Mode

- Erscheinungsort: Separater Tab oder separate Oberfläche innerhalb der Google Suche

- Format: Dynamisch und interaktiv, ermöglicht tiefergehende Folgefragen

- Zweck: Explorative Auseinandersetzung mit komplexeren Themen, Unterstützung bei Aufgaben

- Interaktion: Iterative Dialoge möglich

- Use Cases: Komplexe Recherchen, Planung (Reisen, Einkäufe), kreative Aufgaben, Problem Solving

GEO-Implikation: Während AI Overviews auf schnelle, faktische Antworten optimiert sind, zielt AI Mode auf tiefergehende Exploration ab. Content-Strategien sollten beide Formate berücksichtigen – strukturierte Fakten für AI Overviews, tiefergehende Analysen für AI Mode.

Strategische Erkenntnisse für GEO

Das Verständnis der AI Overview-Architektur liefert konkrete Handlungsempfehlungen für Generative Engine Optimization:

Nicht jede Suchanfrage löst AI Overviews aus. Fokussiere GEO-Maßnahmen auf informative, komplexe Queries, bei denen AI Overviews tatsächlich ausgespielt werden. Transaktionale Keywords bleiben primär SEO- und SEA-Territorium.

Da das System einzelne Chunks bewertet, sollten Inhalte in klar strukturierte, eigenständige Informationseinheiten gegliedert sein. Jeder Abschnitt sollte für sich genommen verständlich und verifizierbar sein.

Widersprüchliche Informationen führen zu negativen Bewertungen. Stelle sicher, dass deine Inhalte konsistent, faktisch korrekt und mit anderen autoritativen Quellen kompatibel sind.

Bei komplexen Queries führt das System Query Fan-Outs durch. Erstelle Content, der nicht nur die Hauptfrage beantwortet, sondern auch verwandte Teilaspekte abdeckt. Umfassende, ganzheitliche Inhalte erhöhen die Citation-Wahrscheinlichkeit.

Die Bewertungsphase prüft Qualität und Verlässlichkeit. Investiere in hochwertige, gut recherchierte Inhalte mit klaren Quellenangaben. Oberflächliche oder spekulative Inhalte werden aussortiert.

Fazit: Suchmaschinen mit LLMs als strategisches GEO-Terrain

Die Analyse der Google AI Overviews zeigt: Suchmaschinen, die Large Language Models nutzen, folgen einer komplexen, mehrstufigen Logik. Von der Eignungsprüfung über Query Fan-Outs bis zur Output-Bewertung – jeder Schritt bietet Ansatzpunkte für gezielte GEO-Optimierung.

Die wichtigsten Erkenntnisse:

- AI Overviews werden nur bei echtem Mehrwert ausgespielt – nicht bei transaktionalen oder sensiblen Queries

- Komplexe Anfragen werden in Teilfragen zerlegt (Query Fan-Out) – umfassende Inhalte profitieren

- Die Bewertung erfolgt auf Chunk-Ebene – strukturierte, eigenständige Informationseinheiten sind optimal

- Konsistenz und Qualität entscheiden über Ausspielung – widersprüchliche oder oberflächliche Inhalte werden aussortiert

Mit diesem Verständnis der technischen Architektur lassen sich GEO-Strategien präzise auf die Funktionsweise von Suchmaschinen mit LLMs abstimmen. In den kommenden Folgen werden wir diese Erkenntnisse in konkrete Taktiken und Workflows übersetzen.

Weitere GEO Know How Folgen